Ministerstwo Edukacji i Nauki 18 lutego 2021 opublikowało aktualizację wykazu z 9 lutego 2021, w związku z czym zamieszczam nowy plik csv (UTF-8, oddzielany średnikami) zmatchowany z wykazem z 2019.

Archiwa tagu: nauka

Impakt rozdziałów, czyli zbiorówki kontratakują

Jednym z elementów wdrażanej właśnie reformy nauki i szkolnictwa wyższego jest modyfikacja formuły oceny jednostek naukowych. Zmian szczegółowych jest sporo, jednak uwagę zwraca przede wszystkim fakt, że zmienia się wyraźnie sposób, w jaki brane będą pod uwagę: autorstwo monografii, redakcja monografii i autorstwo rozdziału w monografii. Przedstawione w sierpniu i wrześniu projekty rozporządzeń z jednej strony selektywnie przesuwają limity na te elementy dorobku naukowego, z drugiej – zmieniają skalę ich punktacji. Przeskakując od razu do konkluzji – zwłaszcza w naukach społecznych i humanistycznych może to się okazać ważny „game changer”. Tylko czy zmiana ta będzie na lepsze czy na gorsze?

Kiedy rozdział wchodzi za mocno…

Zacznijmy od tego, że projekty rozporządzeń proponują, by w ramach ocenianego dorobku autorstwo monografii zwartych oraz redakcje monografii zbiorowych stanowiły nie więcej niż 20% (w porównaniu do dotychczasowych 40%; w naukach przyrodniczych i większości pozostałych limit ma wynieść 5%, ale tam takie publikacje mają zwykle niewielkie znaczenie). Co istotne §7 pkt.13 projektu Rozporządzenia w sprawie ewaluacji… nie wspomina o rozdziałach, więc ich liczba w ankiecie parametryzacyjnej będzie limitowana jedynie zapisem w §7 pkt.7. W praktyce oznacza to, że rozdziały będę mogły stanowić do 2/3 całego dorobku w dyscyplinie.

Monografie mają zostać podzielone na trzy klasy według nieznanej na razie klasyfikacji wydawców. W omawianych tu dziedzinach za autorstwo będzie przyznawane 20, 80 albo 300 punktów, za redakcję 5, 20 albo 150, a za autorstwo rozdziału – 5, 20 albo 75. Jako, że na pierwsze dwa elementy obowiązuje dość niski limit, to trzeci okazać się może kluczowy. Przypomnijmy jednocześnie, że za autorstwo artykułów w czasopismach objętych ministerialnym programem „Wsparcie dla czasopism naukowych” (ma on objąć nie więcej niż 500 najlepszych) przyznawane będzie 20 punktów, natomiast za autorstwo artykułów w czasopiśmie znajdującym się w drugim kwartylu cytowalności (wg Scopusa) – 70 punktów. Sprawia to, że rozdziały w książkach należących do ministerialnych wykazów staną się „funkcjonalnym odpowiednikiem” dobrych krajowych i zagranicznych czasopism.

Dane

Co jednak wiemy o ich realnym naukowym wpływie? Czy wydawnictwa da się „impaktować” podobnie jak czasopisma? Zerknijmy w dostępne dane. Gotowy zbiór przygotował w ramach swojego projektu zespół dra Daniela Torres-Salinasa (zob. Torres-Salinas et al. 2013; 2014; także: projekt EC3Metrics). Są to wskaźniki stworzone w oparciu o dane na temat cytowalności książek z bazy Thomson Reuters. Dane dotyczą okresu 2009-2013 i zostały przygotowane na podstawie prawie pół miliona rekordów (publikacji). Kompletność i trafność informacji nt. książek w bazie Thomson Reuters była przedmiotem dość wszechstronnej krytyki (m.in. dominacja angielskiego, nierówna reprezentacja dyscyplin), jednak sama wielkość bazy czyni ją w jakimś stopniu reprezentatywną. W oparciu o te dane hiszpański zespół stworzył listę 254 wydawnictw naukowych i określił wartości średniej cytowalności. Jednak wiele z tych wydawnictw dotyczyła znikoma liczba publikacji, dlatego dokonałem dalszego filtrowania danych, pozostawiając jedynie te wydawnictwa, w przypadku których liczba pozycji w bazie była wyższa niż 350, a dyspersja ich cytowalności pozwalała wnioskować, że średnia cytowalność jest istotnie wyższa od zera. W efekcie na placu boju zostało 68 wydawnictw, od wielkich komercyjnych graczy jak Routledge, przez mniejsze jak Karger Publishing, po wydawnictwa uniwersyteckie. Z pewnością nie jest to lista aktualna i wyczerpująca, ale traktuję ją jako próbkę dostatecznie wiarygodną, aby powiedzieć coś na temat wzorów dotyczących cytowalności książek.

Dobry i zły pieniądz?

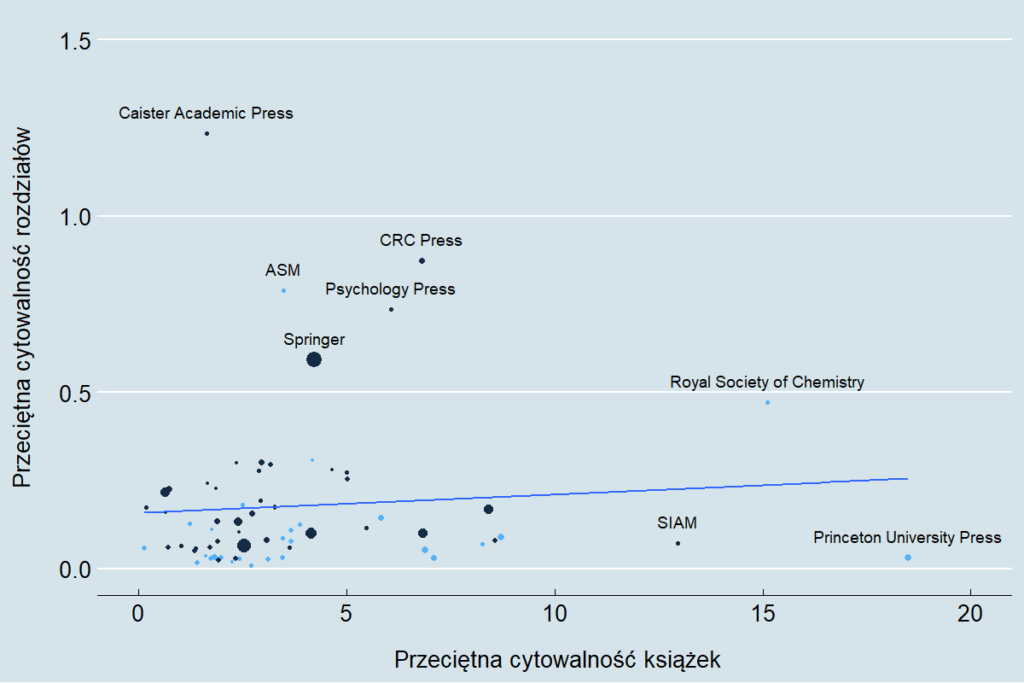

Punkty na przedstawionym niżej wykresie to wydawnictwa naukowe. Błękitne to wydawnictwa uniwersyteckie, a granatowe to pozostałe. Wielkość punktów jest proporcjonalna do liczby pozycji (monografii zwartych i rozdziałów) w zbiorze Torres-Salinasa et consortes. Jak widać, nie obserwujemy wyraźnego wzoru, który sugerowałby, że wydawnictwo, które wydaje ważne i szeroko cytowane książki naukowe, wydaje także bardzo dobre zbiorówki. Korelacja cytowalności dwóch typów publikacji wynosi zaledwie 0,08 (ilustruje to dodana na wykresie linia regresji). Co typowe dla tego typu danych, na lekkie nachylenie linii pracują głównie obserwacje odstające (“lewary”). Największa przeciętna cytowalność książek osiągnęło Princton University Press, a jednak przeciętna cytowalność 5’608 rozdziałów w wydanych przez nich zbiorówkach to zaledwie 0,03. U komercyjnych gigantów też bywa bardzo różnie. Elsevier ma znacznie lepiej “widoczne” niż Springer książki, ale słabiej “widoczne” rozdziały. Z dwoma wyjątkami, wydawnictwa cechują się też większą dyspersją cytowalności (SD), niż jej średnią wartością.

Cytowalność monografii i rozdziałów wg wydawnictw (opracowanie własne; źródło danych: Torres-Salinas et al. 2014)

Kluczowe jest być może to, że istnieje dramatyczna różnica między oddźwiękiem naukowym jaki mają książki, a tym, jaki mają rozdziały. Biorąc pod uwagę łączną liczbę kilkuset tysięcy pozycji uwzględnionych w bazie naukowców z Hiszpanii, do monografii odwoływano się przeciętnie 4,25 razy, a do rozdziału 0,22 razy (to dla wszystkich dyscyplin łącznie, w naukach społecznych i humanistycznych oba wskaźniki były niewątpliwie niższe). “Impakt” rozdziału był zatem przeciętnie prawie 20 razy mniejszy niż zwartej monografii.

Czy polska nauka zachoruje na nową odmianę punktozy?

Jeśli naukowa waga rozdziału jest 20 razy mniejsza niż monografii, to czy rozdziały będą również 20 razy mniej istotne w ocenie dorobku naukowego? Według proponowanych przez MNiSW regulacji za rozdział miałaby być przyznawana czterokrotnie niższa liczba punktów niż za monografię. Jednak realne znaczenie obu elementów wcale nie przedstawia się jak 1 do 4, przede wszystkim ze względu na wspomniane na wstępie limity. Skoro profil osiągnięć publikacyjnych może w odpowiednich okolicznościach wyglądać następująco: 20% książek zwartych (i redakcji), 47% rozdziałów, 33% artykułów, to dobrze punktowane rozdziały mogą się okazać kluczem do dobrego wyniku oceny. Warto także pamiętać, że “próg wejścia” do zagranicznych wydawnictw jest w przypadku rozdziałów znacznie niższy niż w przypadku zwartych książek (w analizowanych danych rozdziałów było 10 razy więcej niż książek). Łącznie ustawia to w pewnym stopniu “strategią wygrywającą” przyszłą parametryzację, choć wiele zależy jeszcze od tego, jak wyglądać będą wykazy KEN. W zależności od tego jak zostaną one sprofilowane, mogą bardziej lub mniej przypominać strukturę impaktów zastosowaną w przypadku artykułów w czasopismach.

ps. Wpis powstał w GESIS w Kolonii. Kiedy zapytałem niemieckich kolegów o rolę, jaką w ocenie dorobku przypisuje się w niemieckiej nauce rozdziałom w pracach zbiorowych, usłyszałem: (a) “Chapters? Nobody cares about chapters!”; (b) “It doesn’t count, unless it’s either Oxford, Cambridge or one of the best US universities”. Takiej aktywności publikacyjnej nie uważa się za w pełni kompetytywną.

Strategie kadrowe polskich instytucji naukowych

Czy duże wydziały i małe centra badawcze mają w Polsce podobne czy różne szanse na uzyskanie wysokiej jakości osiągnięć naukowych? Czy poszczególne dziedziny nauki różnią się pod tym względem? W końcu – czy w Polsce mamy względnie jednolite pole instytucji naukowych, czy też ich pierwszą, drugą i niższe ligi? O tych i paru innych kwestiach piszę w artykule, który ukazał się właśnie na łamach “Nauki”.

Tekst zamieszczony został w wolnym dostępie na stronie czasopisma: http://www.nauka-pan.pl/index.php/nauka/article/view/672.

Nowa lista czasopism punktowanych MNiSW

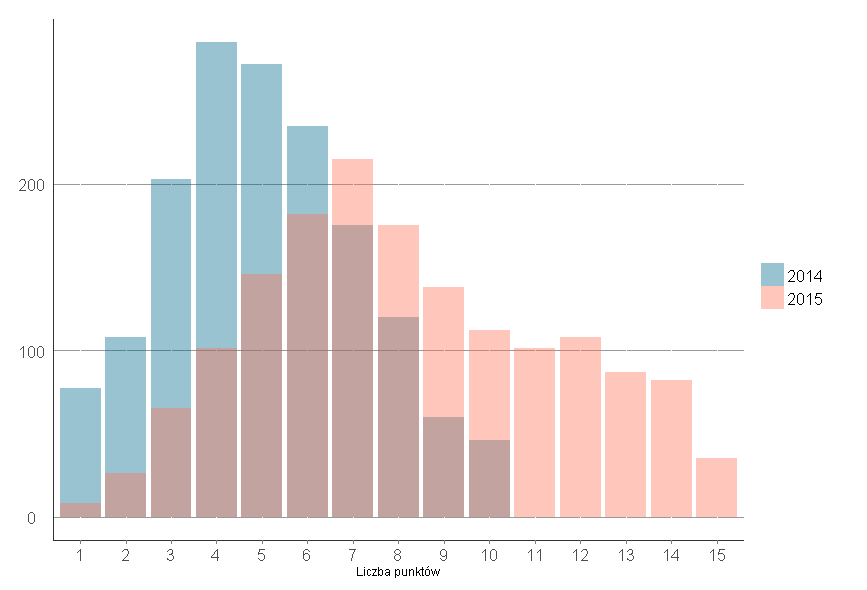

Opublikowana przed świętami nowa lista czasopism punktowanych wywołała sporo kontrowersji. W porównaniu z zeszłym rokiem zmiany dotknęły przede wszystkim listę B, czyli wykaz czasopism krajowych. Mogły one liczyć na dodatkowe 0-5 punktów, które w tej edycji dodawali eksperci z poszczególnych dziedzin (opinia środowiskowa). Zwiększył się w ten sposób zakres ocen tych czasopism – o ile poprzednio punktacja wynosiła tu od 1 do 10 punktów, to obecnie – od 1 do 15 punktów.

Bezpośredniego porównania rozkładu punktacji z roku 2014 i 2015 dokonaliśmy nakładając na siebie dwa histogramy (wykres poniżej). Porównujemy tylko te tytuły, które wystąpiły na liście B zarówno w roku 2014, jak 2015 (co oznacza pełną porównywalność, ale także pominięcie prawie jednej czwartej journali zgłoszonych w bieżącej edycji). W oczy rzuca się przede wszystkim to, że rozkład z 2015 roku ma większy “ogon” po prawej stronie (co zilustrował już Emanuel Kulczycki). Widać, że rozkład z 2014 był w miarę symetryczny wokół średniej, z tym zastrzeżeniem, że czasopism za 9 i 10 było nieco mniej niż tych za 2 i 3 punkty. W 2015 roku pojawiła się wyraźna asymetria o odwrotnym charakterze – mamy wyraźną przewagę liczbową czasopism z wynikiem wyższym niż średni. Takie rozkłady przypominają nieco sytuację, gdy studentom przygotuje się trochę zbyt łatwy test. Mogło się tak stać m.in. dlatego, że eksperci oceniając czasopisma w obrębie własnej dziedziny mieli powody, by przyznawać raczej wysokie noty – trzeba przecież pamiętać, że w parametryzacji konkurują nie tylko same jednostki naukowe, ale całe dyscypliny – zwłaszcza w ramach łączonych GWO (ta dyscyplina, która ma niżej punktowane journale przegrywa w przedbiegach).

O ile w roku 2014 wypadało redakcji cieszyć się z uzyskania 6 lub 7 punktów, ponieważ był to wynik ponadprzeciętny, to te same wartości w 2015 roku oznaczały już znalezienie się poniżej średniej. Ta ostatnia w grupie analizowanych czasopism wzrosła bowiem z 5,1 do 8,2. Gdyby wziąć pod uwagę wszystkie pozycje na liście B z roku 2015, w tym nowe, średnia wynosiłaby niewiele mniej – 7,8.

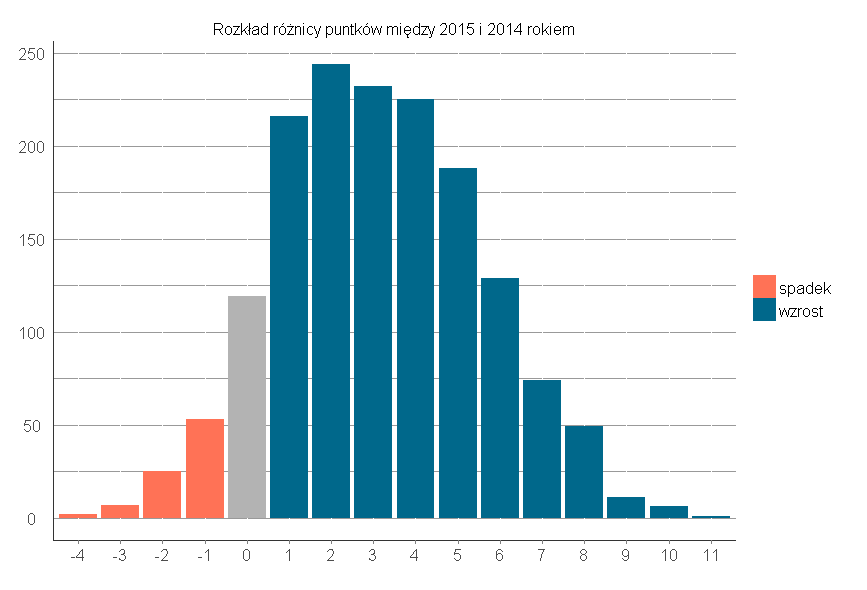

Charakter generalnego kierunku zmiany punktacji pokazuje dokładniej poniższy wykres. Przedstawiony jest na nim rozkład różnicy punktów między 2015 i 2014 rokiem (ponownie – tylko tych czasopism, które były oceniane w ramach listy B w obu latach). Widać tu wyraźnie, że spadków było stosunkowo mało i były one niewielkie. Tytuły straciły od jednego do 4 czterech punktów. Wzrosty wyraźnie przeważały nad spadkami i wyniosły do 11 punktów. Aż 67 czasopism awansowało o 8 lub więcej punktów, wliczając w to spektakularne skoki o 800% (z 1 do 9) czy na drugą stronę skali (z 3 do 14).

Co oznaczają te zmiany w szerszej perspektywie?

(1) Wyraźny wzrost punktacji czasopism krajowych jest tożsamy z relatywnym obniżeniem wagi punktów zdobywanych za publikacje na liście A (gdzie średnia jest bez zmian), czyli w czasopismach zagranicznych posiadających impact factor (wysoką cytowalność). Warto przypomnieć, że w parametryzacji wszystkie artykuły rozpatruje się łącznie (sumując), a w przypadku większości jednostek zdecydowanie dominują publikacje z listy B.

(2) Najwyżej punktowane czasopisma z listy B premiują autorów w tym samym stopniu co te najsłabsze z listy A. Oznacza to, że dobre opinie krajowych badaczy stały się funkcjonalnym ekwiwalentem niższych wartości impact factora.

(3) Jeśli weźmiemy pod uwagę różnicę w trudności publikacji w czasopismach indeksowanych w JCR i krajowych (nawet z powodów translatorskich), to osłabione zostały bodźce do pracy nad tymi pierwszymi.

Skuteczność zdobywania grantów NCN

Od kilku lat przyznawaniem grantów polskim naukowcom zajmuje się NCN (wcześniej robiło to MNiSW). Na podstawie udostępnionych przez tę instytucję danych postanowiliśmy sprawdzić, które spośród największych polskich uczelni są najbardziej

skuteczne w ich pozyskiwaniu.

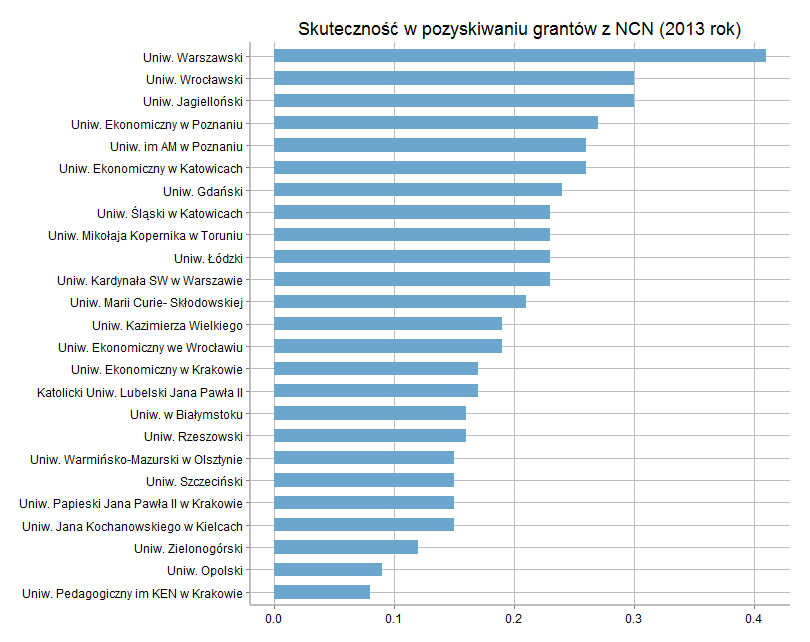

Wykres przedstawia ranking skuteczności rozumianej jako stosunek liczby grantów złożonych do uzyskanych we wszystkich konkursach w 2013 roku. Najbardziej skuteczny – co nie jest wielkim zaskoczeniem – okazał się Uniwersytet Warszawski, którego 40% złożonych grantów zyskało finansowanie. Na drugim i trzecim miejscu znalazły się: Uniwersytet Wrocławski i Jagielloński, w przypadku których co trzeci wniosek grantowy mógł zostać zrealizowany. Na dole rankingu znalazły się mniejsze uczelnie, z mniejszymi tradycjami, takie jak Uniwersytet Pedagogiczny w Krakowie, Uniwersytet Opolski i Zielonogórski. Tylko około co dziesiąty grant z tej trójki zyskał dotację.

Różnice pod względem prawdopodobieństwa uzyskania grantu są jak widać spore, co w części wynika niewątpliwie z jakości składanych wniosków, jednak nie tylko. Konkursy biorą bowiem pod uwagę samą renomę uczelni i jej jednostek, częściowo formalnie i wprost – poprzez kryterium potencjałowe. Można się rzecz jasna domyślać, że także pośrednio i nieformalnie – poprzez idiosynkrazje recenzentów i ekspertów.

Jednocześnie uczelnie przyjmują zróżnicowane strategie starania się o granty. Są takie uczelnie, które składają relatywnie dużo wniosków w stosunku do pracowników, ale mają bardzo niską skuteczność. Taką uczelnią była na przykład “Wyższa Szkoła Finansów i Zarządzania w Warszawie”, która złożyła 31 wniosków, a uzyskała 1 grant. Z drugiej strony są też takie instytucje, jak np. Instytut Nauk Ekonomicznych PAN, który złożył tylko jeden wniosek, ale w konsekwencji jednostka uzyskała 100% skuteczności. Wśród instytucji, które składają większą liczbę wniosków największą skutecznością pochwalić się mogą instytuty nauk ścisłych PAN: Instytut Chemii Organicznej PAN złożył 18 wniosków, a uzyskał 15 grantów, a Instytut Paleobiologii PAN złożył 10, a uzyskał 8.

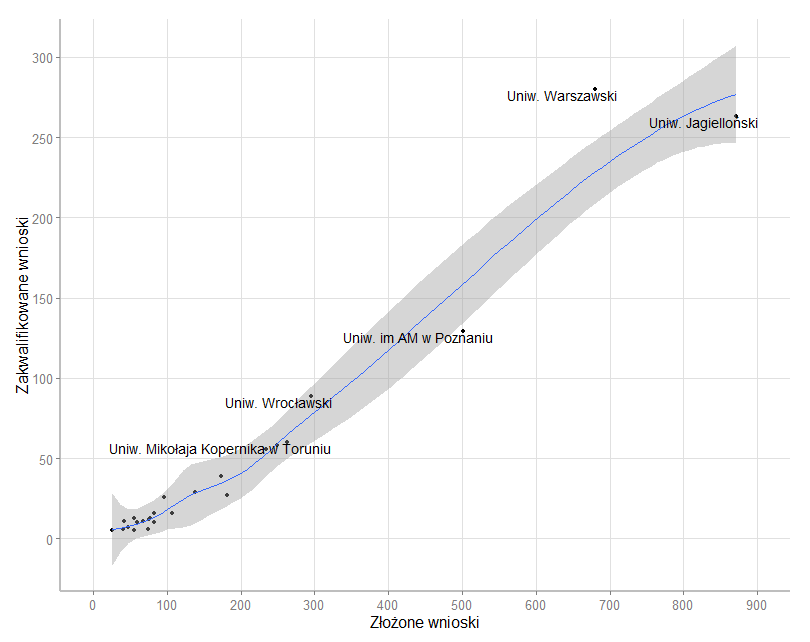

Wykres 2. pokazuje zależność między liczbą składanych wniosków a liczbą sukcesów. Jest ona silna, choć lekko S-kształtna. W 2013 roku krakowski UJ złożył najwięcej grantów (872 wnioski), ale pod względem skuteczności jest dopiero na trzecim miejscu. Fakt ten mógłby bronić ulokowany w Krakowie NCN przed zarzutem stronniczości (z tą oceną przez chwilę się wstrzymajmy). Wykres wydaje się zresztą przekonywać, że wśród 25 wziętych pod uwagę uczelni trudno dostrzec jednoznaczne symptomy dyskryminacji. Uczelnie składają wnioski stosownie do swojego aktualnego potencjału. Jeśli go wyraźnie przekraczają, mogą się liczyć z mniejszą średnią skutecznością albo – przy odrobinie szczęścia – z większą pulą uzyskanych środków. Wydaje się zatem, że w tej specyficznej “grze hazardowej” wypada fortunie dawać przynajmniej szansę – “kupować losy”. Liczy się w bowiem zarówno jakość, jak ilość. Jednocześnie stosunek nakładów (na złożenie wniosku) do korzyści (jakie uzyskuje badacz i jego uczelnia) powinien być jednoznaczną zachętą do pracy nad projektami badawczymi.

Tak się jednak nie dzieje. Nie dysponujemy kompletnymi danymi na temat liczby pracowników poszczególnych uniwersytetów, ale łatwo dać wybiórczą ilustrację. UJ ma co prawda 3 razy więcej pracowników niż UwB, ale jednocześnie składa 10 razy więcej wniosków; UMK ma o jedną trzecią pracowników mniej niż UW, ale składa prawie 3 razy mniej wniosków. Dlaczego tak się dzieje? Pierwsza prawdopodobna odpowiedź dotyczy tego, w jakim stopniu pracownicy definiują swoją rolę jako naukowca, a w jakim jako nauczyciela. Niestety taka definicja sytuacji utrwalana jest przez instytucjonalną konstrukcję systemu finansowania uczelni (pieniądze idą głównie za studentem, a nie za jakością badań). Drugie wyjaśnienie mówi, że pracownicy słabszych uczelni składają względnie mało wniosków, ponieważ są przekonani o mniejszych szansach sukcesu. Wykres 1. pokazał, że są ku temu podstawy, jednak warto zwrócić uwagę na to, że dysproporcje skuteczności są znacznie mniejsze niż dysproporcje podjętych prób.

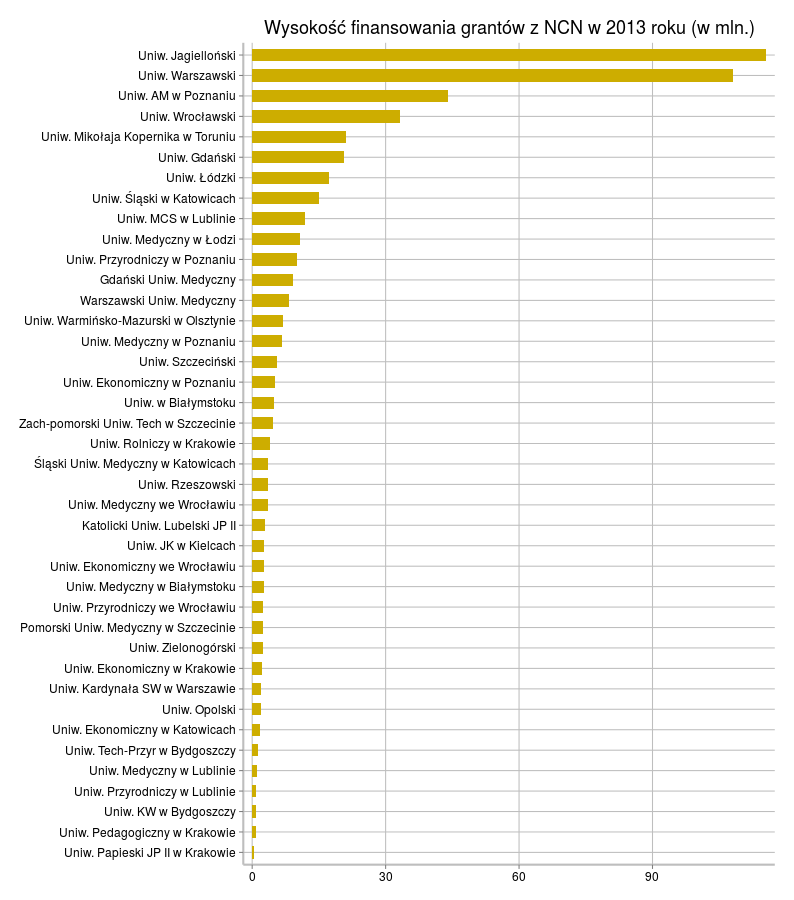

Jest jeszcze jedna rzecz, która liczy się może najbardziej – suma, na jaką projekt opiewa. Z punktu widzenia uczelni (konsumowanych kosztów pośrednich) jest to niewątpliwie statystyka ważniejsza, niż sama liczba realizowanych projektów. Wykres 3. ujmuje łączną kwotę finansowania uzyskaną przez 40 kluczowych polskich uczelni. Kształt rozkładu nie pozostawia wątpliwości, że różnice są bardzo duże. W ramach prezentowanego zestawienia 10% najskuteczniejszych uczelni konsumuje ponad połowę środków. Co ciekawe UJ wypada w tym zestawieniu lepiej niż UW, a zatem mimo nieco mniejszej liczby uzyskanych grantów uzyskał największe ogólne korzyści.

Jest jeszcze jedna rzecz, która liczy się może najbardziej – suma, na jaką projekt opiewa. Z punktu widzenia uczelni (konsumowanych kosztów pośrednich) jest to niewątpliwie statystyka ważniejsza, niż sama liczba realizowanych projektów. Wykres 3. ujmuje łączną kwotę finansowania uzyskaną przez 40 kluczowych polskich uczelni. Kształt rozkładu nie pozostawia wątpliwości, że różnice są bardzo duże. W ramach prezentowanego zestawienia 10% najskuteczniejszych uczelni konsumuje ponad połowę środków. Co ciekawe UJ wypada w tym zestawieniu lepiej niż UW, a zatem mimo nieco mniejszej liczby uzyskanych grantów uzyskał największe ogólne korzyści.

Wykres nie pozostawia złudzeń – pod względem skali prowadzonych badań w Polsce jest kilka osobnych klas uczelni. Do pierwszej nalezą tylko UJ i UW. Do drugiej UAM i UWr. Dalszy podział staje się coraz bardziej płynny, ale także ma coraz mniejszy sens – udział środków grantowych w całkowitym budżecie uczelni staje się po prostu (w większości przypadków) mało znaczący.

Wykres nie pozostawia złudzeń – pod względem skali prowadzonych badań w Polsce jest kilka osobnych klas uczelni. Do pierwszej nalezą tylko UJ i UW. Do drugiej UAM i UWr. Dalszy podział staje się coraz bardziej płynny, ale także ma coraz mniejszy sens – udział środków grantowych w całkowitym budżecie uczelni staje się po prostu (w większości przypadków) mało znaczący.